Практическое занятие №1 Определение количества информации

МЕТОДИЧЕСКИЕ УКАЗАНИЯ

к практическим занятиям

по дисциплине “Теория информации”

МЕТОДИЧЕСКИЕ УКАЗАНИЯ

к практическим занятиям

по дисциплине “Теория информации”

(для студентов, обучающихся по специальностям “Автоматизированное управление технологическими процессами” и “Системы управления и автоматика”)

У Т В Е Р Ж Д Е Н О

на заседании кафедры

автоматики и систем управления

Протокол № _от __.__.2003г.

УДК 681.5.01

Методические указания к практическим занятиям по курсу “Теория информации ” (для студентов специальности 7.0925.01 и 7.0914.01) / Авторы Б.Н.Локотош, А.В.Колесников.-Луганск: Изд-во ВНУ имени Владимира Даля, 2003.- __с.

Рассматриваются типовые задачи и их решение курса «Теория информации». Изложены методики расчета количества информации, определения энтропии и объема информации в сообщении, вычисления информационных потерь при передаче сообщений по каналам связи с шумами, избыточность сообщений, оптимального неравномерного кодирования (коды Шеннона и Хаффмана.

Авторы Б.Н.Локотош, проф.,

А.В.Колесников, асист.

Рецензент В.А. Ульшин, проф.

Зав. каф. Ю.Г. Войлов, проф.

-

Известно, что одно из К известных сообщений, передаваемых равномерным двоичным кодом имеет 3 бита информации. Чему равно К?

![]()

-

Определить количество информации на одну букву алфавита состоящего из 16 букв. m1=16, I=?

![]()

-

Число символов алфавита m1=5. Определить количество информации на один символ сообщения, составленного из этого алфавита для двух случаев:

-

если символы равновероятны;

-

если имеются следующие равновероятности: P1=0,8; P2=0,15; P3=0,03; P4=0,015; P5=0,005; Pi=1.

Э нтропия любого алфавита равна сумме произведений вероятностей на логарифмы этих вероятностей.

нтропия любого алфавита равна сумме произведений вероятностей на логарифмы этих вероятностей.

-

В плановом отделе завода работают 3 экономиста. Два опытных, один – нет. Для неопытного появление любого типа документа из цехов равновероятно. Опытные знают: PS=10% – сводка типа S. Какое количество информации получат каждый экономист при получении сводки типа S.

![]()

-

Сколькими способами можно передать расположение фигур на шахматной доске? Чему равно количество информации в каждом предлагаемом случае?

-

-P. При каком значении q, результат опыта Вероятность определенного события при данном количестве опытов равно Р, вероятность непоявления этого события равна q=1будет обладать максимальной неопределенностью.

-

Имеется система, которая задана параметрами:

Таблица 1.1

|

xi |

x1 |

x2 |

x3 |

x4 |

|

Pi |

0.1 |

0.2 |

0.3 |

0.4 |

Чему равна Н всей системы, состояние которой описывается дискретной величиной? Распределение вероятности указано в таблице.

П о условию задачи имеется двоичный код для подсчитывания информации:

о условию задачи имеется двоичный код для подсчитывания информации:

-

Г

енератор вырабатывает 4 частоты, в шифраторе комбинируется по 3 частоты в кодовой комбинации. Определить общее количество символов первичного алфавита, которое может быть передано в этом случае. Определить количество информации на одну кодовую посылку (одно сообщение).

енератор вырабатывает 4 частоты, в шифраторе комбинируется по 3 частоты в кодовой комбинации. Определить общее количество символов первичного алфавита, которое может быть передано в этом случае. Определить количество информации на одну кодовую посылку (одно сообщение). -

Определить объем и количество информации в тексте со стандартным телефонным кодом №3, который имеет 7 символов. Код – равномерный (lср= n).

« Широка страна моя родная» – 24 символа

Широка страна моя родная» – 24 символа

10. В сообщении переданы символы равновероятного первичного ал фавита, который имеет 128 качественных признаков. Чему равно количество символов n, в принятом сообщении, если оно кодируется двоичным кодом и содержит 42 бита информации?

-

Чему равно количество информации при получении сообщения о выходе из строя одного из 8 станков, полученное в одно и тоже время с этого завода?

![]()

-

Алфавит состоит из букв А, В, С, Д. Вероятность появления: РА=РВ=0,28, РС=0,34, РД=0,1. Определить количество энтропии на символ сообщения, составленного из такого алфавита?

Задачи

Задача 1.1. Известно, что одно из К сообщений, передаваемых равномерным двоичным кодом имеет I бит информации. Чему равно К?

Задача 1.2. Определить количество информации на одну букву алфавита состоящего из m1 букв.

Задача 1.3. Число символов алфавита m1. Определить количество информации на один символ сообщения, составленного из этого алфавита для двух случаев:

а) если символы равновероятны;

б) если имеются следующие вероятности их появления в текстовых сообщениях : Pi ={P1; P2; …Pm1}

|

№ варианта |

Задача 1.1 |

Задача 1.2 |

Задача 1.3 |

||||||

|

I, бит |

m1 |

m1 |

P1 |

P2 |

P3 |

P4 |

P5 |

P6 |

|

|

1 |

2 |

10 |

3 |

0,2 |

0,5 |

0,3 |

|||

|

2 |

3 |

12 |

4 |

0,3 |

0,4 |

0,1 |

0,2 |

||

|

3 |

4 |

14 |

5 |

0,2 |

0,3 |

0,4 |

0,05 |

0,05 |

|

|

4 |

5 |

16 |

6 |

0,1 |

0,2 |

0,2 |

0,1 |

0,3 |

0,1 |

|

5 |

6 |

18 |

3 |

0,1 |

0,6 |

0,3 |

|||

|

6 |

7 |

20 |

3 |

0,2 |

0,4 |

0,4 |

|||

|

7 |

2 |

22 |

4 |

0,08 |

0,2 |

0,4 |

0,32 |

||

|

8 |

3 |

24 |

5 |

0,2 |

0,4 |

0,1 |

0,1 |

0,2 |

|

|

9 |

4 |

26 |

6 |

0,1 |

0,2 |

0,1 |

0,3 |

0,1 |

0,2 |

|

10 |

5 |

28 |

3 |

0,2 |

0,5 |

0,3 |

|||

|

11 |

6 |

30 |

4 |

0,1 |

0,6 |

0,1 |

0,2 |

||

|

12 |

7 |

32 |

5 |

0,2 |

0,3 |

0,4 |

0,05 |

0,05 |

|

|

13 |

2 |

34 |

6 |

0,1 |

0,2 |

0,2 |

0,1 |

0,3 |

0,1 |

|

14 |

3 |

36 |

3 |

0,1 |

0,6 |

0,3 |

|||

|

15 |

4 |

10 |

4 |

0,2 |

0,4 |

0,3 |

0,1 |

||

|

16 |

5 |

12 |

5 |

0,04 |

0,12 |

0,21 |

0,63 |

||

|

17 |

6 |

14 |

6 |

0,2 |

0,3 |

0,1 |

0,1 |

0,2 |

0,1 |

|

18 |

7 |

16 |

3 |

0,18 |

0,36 |

0,46 |

|||

|

19 |

2 |

18 |

4 |

0,12 |

0,13 |

0,28 |

0,47 |

||

|

20 |

3 |

20 |

5 |

0,22 |

0,13 |

0,19 |

0,38 |

0,08 |

|

|

21 |

4 |

22 |

6 |

0,06 |

0,03 |

0,11 |

0,23 |

0,09 |

0,48 |

|

22 |

5 |

24 |

3 |

0,26 |

0,38 |

0,36 |

|||

|

23 |

6 |

26 |

4 |

0,31 |

0,24 |

0,13 |

0,32 |

||

|

24 |

7 |

28 |

5 |

0,27 |

0,07 |

0,15 |

0,23 |

0,28 |

|

|

25 |

2 |

30 |

6 |

0,01 |

0,06 |

0,14 |

0,19 |

0,29 |

0,31 |

StudFiles.ru

/ Лекции по информатике / Количество информации

Количество информации как мера уменьшения неопределенности знаний

Количество информации как мера уменьшения неопределенности знаний.Информацию, которую получает человек, можно считать мерой уменьшения неопределенности знаний. Если некоторое сообщение приводит к уменьшению неопределенности наших знаний, то можно говорить, что такое сообщение содержит информацию.

Сообщения обычно содержат информацию о каких-либо событиях. Количество информации для событий с различными вероятностями определяется по формуле:

|

|

где I – количество информации,

N – количество возможных событий,

pi- вероятности отдельных событий.

Если события равновероятны, то количество информации определяется по формуле:

|

I = log2N |

или из показательного уравнения:

|

N= 2I. |

Пример 2.1.После экзамена по информатике, который сдавали ваши друзья, объявляются оценки («2», «3», «4» или «5»). Какое количество информации будет нести сообщение об оценке учащегосяA, который выучил лишь половину билетов, и сообщение об оценке учащегосяB, который выучил все билеты.

Опыт показывает, что для учащегося Aвсе четыре оценки (события) равновероятны и тогда количество информации, которое несет сообщение об оценке можно вычислить по формуле 2.2:

I = log24 = 2 бит

На основании опыта можно также предположить, что для учащегося Bнаиболее вероятной оценкой является «5» (p1 = 1/2), вероятность оценки «4» в два раза меньше (p2 = 1/4), а вероятности оценок «2» и «3» еще в два раза меньше (p3 = p4= 1/8). Так как события неравновероятны, воспользуемся для подсчета количества информации в сообщении формулой 2.1:

I = -(1/2Elog21/2 + 1/4Elog21/4 + 1/8Elog21/8 + 1/8Elog21/8) бит = 1,75 бит

Вычисления показали, что при равновероятных событиях мы получаем большее количество информации, чем при неравновероятных событиях.

Пример 2.2.В непрозрачном мешочке хранятся 10 белых, 20 красных, 30 синих и 40 зеленых шариков. Какое количество информации будет содержать зрительное сообщение о цвете вынутого шарика.

Так как количество шариков различных цветов неодинаково, то зрительные сообщения о цвете вынутого из мешочка шарика также различаются и равны количеству шариков данного цвета деленному на общее количество шариков:

pб = 0,1; pк = 0,2; pз = 0,3; pс = 0,4

События неравновероятны, поэтому для определения количества информации, содержащимся в сообщении о цвете шарика, воспользуемся формулой 2.1:

I = -(0,1·log2 0,1+ 0,2·log2 0,2 + 0,3·log2 0,3 + 0,4·log2 0,4) бит

Пример 2.3.Какое количество вопросов достаточно задать вашему собеседнику, чтобы наверняка определить месяц, в котором он родился?

Будем рассматривать 12 месяцев как 12 возможных событий. Если спрашивать о конкретном месяце рождения, то, возможно, придется задать 11 вопросов (если на 11 первых вопросов был получен отрицательный ответ, то 12-й задавать не обязательно, так как он и будет правильным).

Правильно задавать «двоичные» вопросы, т.е. вопросы, на которые можно ответить только «Да» или «Нет». Например, «Вы родились во второй половине года?». Каждый такой вопрос разбивает множество вариантов на два подмножества: одно соответствует ответу «Да», а другое — ответу «Нет».

Правильная стратегия состоит в том, что вопросы нужно задавать так, чтобы количество возможных вариантов каждый раз уменьшалось вдвое. Тогда количество возможных событий в каждом из полученных подмножеств будет одинаково и их отгадывание равновероятно. В этом случае на каждом шаге ответ («Да» или «Нет») будет нести максимальное количество информации (1 бит).

По формуле 2.2 и с помощью калькулятора получаем:

I = log212 »3,6 бит

Количество полученных бит информации соответствует количеству заданных вопросов, однако количество вопросов не может быть нецелым числом. Округляем до большего целого числа и получаем ответ: при правильной стратегии необходимо задать не более 4 вопросов.

Единицы измерения количества информации

Единицы измерения количества информации.За единицу количества информации принят 1 бит — количество информации, содержащееся в сообщении, уменьшающем неопределенность знаний в два раза.

Принята следующая система единиц измерения количества информации:

1 байт = 8 бит

1 Кбайт = 210байт

1 Мбайт = 210Кбайт = 220байт

1 Гбайт = 210Мбайт = 220Кбайт = 230байт

Определение количества информации, представленной с помощью знаковых систем

Если рассматривать символы алфавита как множество возможных сообщений (событий) N, то количество информации, которое несет один знак можно определить из формулы 2.1. Если считать появление каждого знака алфавита в тексте событиями равновероятными, то для определения количества информации можно воспользоваться формулой 2.2 или уравнением 2.3.

Количество информации, которое несет один знак алфавита тем больше, чем больше знаков входят в этот алфавит, т.е. чем больше мощность алфавита.

Количество информации, содержащейся в сообщении, закодированном с помощью знаковой системы, равно количеству информации, которое несет один знак, умноженному на число знаков в сообщении.

Пример 2.5.Какова мощность алфавита, с помощью которого записано сообщение, содержащее 2048 символов, если его объем составляет 1,25 Кбайта.

Перевести информационный объем сообщения в биты:

.I = 10 240 бит

Определить количество бит, приходящееся на один символ:

10 240 бит : 2 048 = 5 бит

По формуле 2.3 определить количество символов в алфавите:

N= 2I = 25 = 32

StudFiles.ru

2.1.2. Определение количества информации

При этом

|

|

(2.2) |

|

|

(2.3) |

Из (2.2) и (2.3) следует, что неопределенность отсутствует в том и только том случае, когда одно из ![]() равно 1. Максимальная неопределенность достигается при

равно 1. Максимальная неопределенность достигается при![]() , т.е. когда существует равномерное распределение случайных событий, отражающих состояние случайного объекта или явления. В то же время для равносильного, например равновероятного, распределения неопределенность возрастает с возрастаниемn. Последнее свидетельствует о том, что энтропия (2.1) является как мерой неопределенности, так и мерой разнообразия. Это означает, что чем сложнее, чем разнообразнее объект или явление, тем большей неопределенностью он обладает или, другими словами, тем менее прогнозируемыми становятся объекты или явления.

, т.е. когда существует равномерное распределение случайных событий, отражающих состояние случайного объекта или явления. В то же время для равносильного, например равновероятного, распределения неопределенность возрастает с возрастаниемn. Последнее свидетельствует о том, что энтропия (2.1) является как мерой неопределенности, так и мерой разнообразия. Это означает, что чем сложнее, чем разнообразнее объект или явление, тем большей неопределенностью он обладает или, другими словами, тем менее прогнозируемыми становятся объекты или явления.

В случае, когда представляется как континуум, например, для случайной величины Х, принимающей бесконечное несчетное множество значений, где x X, энтропия вычисляется по формуле

|

|

(2.4) |

|

при |

Основание логарифма в формулах (2.1) и (2.4) не оказывает качественного влияния на оценку энтропии, а лишь определяет ее размерность. Для непрерывных случайных величин, непрерывных случайных процессов при теоретическом анализе, включающем интегрирование или дифференцирование математических выражений, наиболее удобно использовать натуральные логарифмы, при этом энтропия определяется в натуральных единицах нитах (или хартли). При анализе цифровых машин и других устройств, работающих в двоичном коде, как правило, используются двоичные логарифмы и соответственно двоичные единицы биты. При анализе измерительных устройств, работающих в десятичном коде, удобнее применять десятичные логарифмы и десятичные единицы диты. Между этими единицами существуют определенные соотношения: 1 дит = 2,3 нит = 3,3 бит, 1 нит = 1,45 бит = 0,43 дит, 1 бит = 0,69 нит = 0,3 дит. Указанное в полной мере относится к единице измерения количества информации. Например, для такого объекта (явления), как монета (подбрасывание монеты), характерны два равновероятных случайных состояния (события): выпадение решки или орла. Энтропия этого явления

![]()

![]()

Для бутерброда также возможны два состояния: хлеб и масло. На основании известного в народе «закона» о том, что бутерброд всегда падает маслом вниз, ![]()

При n = 2 неопределенность (непредсказуемость) исхода в подбрасывании максимальна в случае с монетой; для бутерброда неопределенность отсутствует.

При увеличении n, например n = 6 для игрального кубика, с учетом равновероятного распределения возможных состояний

![]() бит.

бит.

Для двух и более случайных объектов или явлений энтропия определяется аналогично вероятности, т.е. с увеличением n энтропия возрастает.

Если и независимые случайные объекты или явления, то

|

|

(2.5) |

т.е. энтропия двух или нескольких независимых объектов или явлений равна сумме энтропий этих объектов или явлений. Это свойство аддитивности энтропии.

Если и – зависимые случайные объекты или явления, то

|

|

(2.6) |

где H(/)или H(/)определяются как математическое ожидание энтропии условного распределения.

Для всех случайных объектов или явлений имеет место неравенство ![]() , это согласуется с интуитивным представлением о том, что знание состоянияможет только уменьшить неопределенность , а если они независимы, т.е.

, это согласуется с интуитивным представлением о том, что знание состоянияможет только уменьшить неопределенность , а если они независимы, т.е. ![]() , то оставить ее неизменной.

, то оставить ее неизменной.

Пример 2.1. Неопределенность даты проведения ежегодного мероприятия можно определить двумя путями:

![]()

где 365 – число дней в году;

где 12 – число месяцев в году; 30 – число дней в месяце.

Пример 2.2. Специалист, занимающийся проблемой В, для информационного обеспечения своей интеллектуальной деятельности воспользовался автоматизированной информационно-поисковой системой (АИПС). В базе АИПС содержится 2 % статей, непосредственно относящихся к данной проблеме. Система поиска в АИПС точно обнаруживает эти статьи по запросу. В то же время ввиду некоторой близости тематики других статей к проблеме В эта система с равной вероятностью может представить или не представить специалисту статьи, не относящиеся непосредственно к проблеме В. Определить эффект системы поиска, используя меру снятия неопределенности по отношению к проблеме В.

Решение. Формализуем представленную ситуацию. Определение отношения той или иной статьи к проблеме В представим как опыт , имеющий два возможных исхода:

В1 «не относится»;

В2 «относится».

Определение эффективности системы поиска представим как опыт , также имеющий два возможных исхода:

А1 «определен признак В»;

А2 «не определен признак В».

Вероятности определения и неопределения признака В соответственно равны:

Неопределенность отношения той или иной статьи к проблеме В

![]() бит.

бит.

Это есть неопределенность базы АИПС по отношению к проблеме В. В целом, с учетом эффективности работы системы поиска, т.е. опыта , неопределенность АИПС можно вычислить через условную энтропию ![]() . Для этого определим:

. Для этого определим:

условные вероятности исходов В1иВ2опыта при условии исходов А1и А2опыта :

![]() ,

,

т.к. из 51 случая, когда система поиска давала положительный ответ, 49 статей не относились к проблеме В, а 2 статьи относилась,

![]()

что вполне очевидно;

условные энтропии АИПС (при условиях А1и А2):

Тогда средняя условная энтропия опыта (неопределенность АИПС) при условии существования системы поиска (опыт ) будет равна математическому ожиданию энтропии условного распределения:

![]()

Если сравнить значение H(/) с ранее полученным значением неопределенности базы АИПС Н(), то можно констатировать, что система поиска в данном случае недостаточно эффективна, поскольку снимает неопределенность АИПС всего на 14 %.

Задания для самостоятельной работы

1. Определите энтропию русского алфавита в случае равновероятного распределения букв. Возьмите текст любой книги (1–2 страницы). Определите вероятности появления букв в том тексте и вычислите энтропию. Сравните ее с предыдущей и объясните причину появления разницы.

2. Проведите в вашей группе следующий эксперимент. Выберите два различных предмета (например, кусок мела и стул). Каждый студент должен написать прилагательные, которые могут охарактеризовать сначала первый, а затем второй предмет. Для выполнения этой процедуры выделите одинаковое время на описание каждого предмета (например, 2 мин). Затем выпишите на доске все прилагательные, которые встречаются в записках по каждому предмету. Вычислите частоту (апостериорную вероятность) появления каждого прилагательного. На основании статистических данных определите энтропии двух предметов по формуле (2.1). Используя энтропию как меру неопределенности и меру разнообразия, дайте информационную характеристику рассматриваемых предметов.

Отбросьте прилагательные, которые упоминаются только один раз. Определите энтропии предметов на основании вновь образованных множеств прилагательных и их вероятностей. Сделайте выводы.

Используя полученные распределения вероятностей, определите 3 – 4 наиболее характерные особенности (прилагательных) рассматриваемых предметов. Предложите группе, не знакомой с данным экспериментом, на основании этих 3 4 прилагательных определить, о каком предмете идет речь. Пусть попробуют сделать то же самое на основании 3 4 прилагательных, находящихся в противоположном конце распределения вероятностей. Найдите вероятность распознавания предмета в том и другом случае.

3. Из 100 обследованных пациентов 5 имели болезнь А. Система диагностики заболевания обнаружила признаки болезни А у 25 пациентов. Какова эффективность системы диагностики?

Пусть случайный объект или явление имеет неопределенность Н(). Любой целенаправленный опыт , имеющий определенное количество исходов (сообщений, результатов, измерений), уменьшает степень неопределенности . Разность

|

|

(2.7) |

где Н() – априорная, а Н(/) – апостериорная энтропии (неопределенности) объекта или явления есть количество информации (или числовое значение количества информации в битах) об объекте или явлении , полученной в результате опыта . В этом случае I(,)представляется как мера снятия неопределенности, а процесс получения информации об объекте или явлении – как процесс снятия неопределенности.

Если результат (исходы) опыта полностью определяет все сведения, которыми обладает , то Н(/) становится равным 0, а

|

|

(2.8) |

В этом случае можно считать, что получена полная информация об объекте или явлении , отражающая все его свойства и являющаясямерой разнообразия объектов или явлений. Так раскрывается атрибутивная концепция информации, которая определяет информацию как объективный атрибут материи.

ЕслиН(/) = Н(), то следует, что в результате опыта (а фактически любой информационной деятельности) не получено никакой информации об объекте или явлении , т.е. I(,) = 0.

Из приведенных утверждений следуют важные практические выводы, определяющие эффективность информационной деятельности:

информационная деятельность считается эффективной, если она приводит к снятию неопределенности (2.7);

эффективность информационной деятельности может быть оценена количественно; предел, к которому стремится эта оценка, определяется выражением (2.8).

Значение I(, )определяется выражением (2.7) как количество информации относительно объекта или явления , содержащейся в опыте , а выражением (2.8) как количество информации о , полученной объектом . Последнее свидетельствуют о том, что I(,)есть мера сравнения двух объектов.

В результате сравнения объекта с объектами и получим следующие количества информации:

|

|

(2.9) |

и

|

|

(2.10) |

Очевидно, при ![]() будет справедливо неравенство

будет справедливо неравенство![]() , а следовательно,

, а следовательно,![]() . Это означает, что различные субъекты (или ), обладающие различной энтропией или информацией, при исследовании одного и того же объекта () могут получить различное количество информации. Разность

. Это означает, что различные субъекты (или ), обладающие различной энтропией или информацией, при исследовании одного и того же объекта () могут получить различное количество информации. Разность

|

|

(2.11) |

можно рассматривать как меру сравнения информированности объектов (или субъектов) и об объекте или явлении . Это обстоятельство является важной предпосылкой семантической теории информации.

Пример 2.3. В качестве объекта возьмем русскую письменную речь. В русском алфавите 32 буквы (без различия е и ё). C первого взгляда для нас как субъектов наблюдения неопределенность русской письменной речи .

Решение. Неопределенность в случае равномерного распределения букв алфавита:

![]() бит.

бит.

Проведем опыт ![]() в целях определения истинного (а не равновероятного) распределения вероятностей появления отдельных букв в русской речи. В результате опыта

в целях определения истинного (а не равновероятного) распределения вероятностей появления отдельных букв в русской речи. В результате опыта![]() получим данные, приведенные в табл.1.1. На основании этих данных (этой информации) получим

получим данные, приведенные в табл.1.1. На основании этих данных (этой информации) получим

![]()

Тогда

![]() бит.

бит.

Такое количество информации содержится в таблице или получено в результате опыта ![]() . Далее проведем опыт

. Далее проведем опыт![]() , определяющий возможные связи между парами отдельных букв русского алфавита в письменной речи. В результате получим

, определяющий возможные связи между парами отдельных букв русского алфавита в письменной речи. В результате получим

Тогда

![]()

Такое количество информации получено в результате опыта ![]() , проведенного после опыта

, проведенного после опыта![]() .

.

Задания для самостоятельной работы

1. Определите, какое количество информации можно получить:

от системы поиска АИПС (для примера 2.2);

системы диагностики заболевания (задание 3 на стр. 68).

2. В учебном корпусе 150 аудиторий: ![]() . Студент, получив дополнительную информацию, пришел к выводу, что его группа с вероятностью 0,8 находится в аудитории

. Студент, получив дополнительную информацию, пришел к выводу, что его группа с вероятностью 0,8 находится в аудитории![]() . Определите количество дополнительной информации.

. Определите количество дополнительной информации.

3. Спланируйте опыт , который позволил бы определить информированность субъектов ![]() и

и![]() об объекте.

об объекте.

StudFiles.ru

Алфавитный подход к определению количества информации

При алфавитном подходе к определению количества информации отвлекаются от содержания информации и рассматривают информационное сообщение как последовательность знаков определенной знаковой системы.

Информационная емкость знака. Представим себе, что необходимо передать информационное сообщение по каналу передачи информации от отправителя к получателю. Пусть сообщение кодируется с помощью знаковой системы, алфавит которой состоит из N знаков {1, ..., N}. В простейшем случае, когда длина кода сообщения составляет один знак, отправитель может послать одно из N возможных сообщений "1", "2", ..., "N", которое будет нести количество информации I (рис. 1.5).

|

| Рис. 1.5. Передача информации |

Формула (1.1) связывает между собой количество возможных информационных сообщений N и количество информации I, которое несет полученное сообщение. Тогда в рассматриваемой ситуации N - это количество знаков в алфавите знаковой системы, а I - количество информации, которое несет каждый знак:

N = 2I.

С помощью этой формулы можно, например, определить количество информации, которое несет знак в двоичной знаковой системе:

N = 2 => 2 = 2I => 21 = 2I => I=1 бит.

Таким образом, в двоичной знаковой системе знак несет 1 бит информации. Интересно, что сама единица измерения количества информации "бит" (bit) получила свое название ОТ английского словосочетания "Binary digiT" - "двоичная цифра".

Информационная емкость знака двоичной знаковой системы составляет 1 бит.

Чем большее количество знаков содержит алфавит знаковой системы, тем большее количество информации несет один знак. В качестве примера определим количество информации, которое несет буква русского алфавита. В русский алфавит входят 33 буквы, однако на практике часто для передачи сообщений используются только 32 буквы (исключается буква "ё").

С помощью формулы (1.1) определим количество информации, которое несет буква русского алфавита:

N = 32 => 32 = 2I => 25 = 2I => I=5 битов.

Таким образом, буква русского алфавита несет 5 битов информации (при алфавитном подходе к измерению количества информации).

Количество информации, которое несет знак, зависит от вероятности его получения. Если получатель заранее точно знает, какой знак придет, то полученное количество информации будет равно 0. Наоборот, чем менее вероятно получение знака, тем больше его информационная емкость.

В русской письменной речи частота использования букв в тексте различна, так в среднем на 1000 знаков осмысленного текста приходится 200 букв "а" и в сто раз меньшее количество буквы "ф" (всего 2). Таким образом, с точки зрения теории информации, информационная емкость знаков русского алфавита различна (у буквы "а" она наименьшая, а у буквы "ф" - наибольшая).

Количество информации в сообщении. Сообщение состоит из последовательности знаков, каждый из которых несет определенное количество информации.

Если знаки несут одинаковое количество информации, то количество информации Ic в сообщении можно подсчитать, умножив количество информации Iз, которое несет один знак, на длину кода (количество знаков в сообщении) К:

Ic = Iз × K

Так, каждая цифра двоичного компьютерного кода несет информацию в 1 бит. Следовательно, две цифры несут информацию в 2 бита, три цифры - в 3 бита и т. д. Количество информации в битах равно количеству цифр двоичного компьютерного кода (табл. 1.1).

Таблица 1.1. Количество информации, которое несет двоич ный компьютерный код

| Двоичный компьютерный код | |||

| Количество информации | 1 бит | 1 бит | 1 бит |

|

Понятие ценности информации, вводимое в настоящей главе, связывает шенноновскую теорию информации с теорией стастисти-ческих решений. В последней теории основным является понятие средних потерь или риска, которое характеризирует качество принимаемых решений. Ценность информации специализируется как та максимальная польза, которую данное количество информации способно принести в деле уменьшения средних потерь. Такое определение ценности информации оказывается связанным с формулировкой и решением определенных условных вариационных задач. [1]

Ввести понятие ценности информации можно тремя родственными способами, выбирая за основу хартлиевское, больцмановское или шенноновское количество информации. При выборе шеннонов-ского количества информации нужно решать третью вариационную задачу. Между указанными определениями существует известная связь, и одно понятие может служить удобной заменой другого. Все эти понятия характеризуют определенный объект - бейесов-скую систему, который наряду с каналом является важнейшим объектом исследования теории информации. [2]

Вводится понятие ценности информации и демонстрируются различные варианты понятия макси-мина ( наилучшего гарантированного результата) в зависимости от информированности об обстановке операций. Излагаются необходимые условия максимина и примеры его определения для ряда моделей операций, имеющих не только учебный характер. [3]

Таким образом, понятие ценности информации, введенное в предыдущем разделе, шире понятия сложности и, в сущности, включает сложность. Пользуясь понятием ценности, можно преодолеть трудность, связанную с тем, что в эволюции может происходить не усложнение, но упрощение. [4]

Важно отметить, что понятие ценности информации, используемой при контроле функционирования АС, является многогранным и в значительной мере субъективным. Многогранность понятия определяется, с одной стороны, степенью соответствия получаемой информации конкретной задаче контроля, а с другой - возможностью, целесообразностью и своевременностью ее получения. Так, например, интуитивно ясно, что состояние сложной энергетической системы определяется уровнем вырабатываемой или аккумулируемой энергии. [5]

Мы видим, что понятие сложности сходно с понятием ценности информации, рассмотренным в предыдущем параграфе. [6]

Для того чтобы правильно ставить такого рода вопросы, необходимо ввести понятие ценности информации, и это в дальнейшем будет сделано в полном соответствии с проводимыми здесь идеями о сравнении эффективности стратегий вообще. [7]

Таким образом, последнее условие ( хотя оно часто и не принимается во внимание) имеет по существу главное определяющее значение в формулировке понятия ценности информации. [8]

Уменьшение избыточной информации может быть выполнено на основании анализа ценности информации для управления. Как известно, понятие ценности информации не вытекает из самой теории информации, основанной на статистической трактовке вопросов. [9]

Здесь не рассматривается генерация информации и ее инструктирующее значение, определяющее ту или иную биологическую функцию носителя информации. При исследовании развивающейся и эволюционирующей системы необходимо ввести понятие ценности информации для реализации конкретного процесса, эквивалентное ее программирующему, инструктирующему, значению. Ценность информации выражает ее содержание, тогда как количество информации не имеет отношения к ее содержанию. Содержание можно оценить лишь применительно к определенным физическим процессам. [10]

В общем случае работа динамической биологической системы означает реализацию инструктивного, программирующего значения информации, содержащейся в конечном счете в биологических макромолекулах нуклеиновых кислот и белков. Модельное описание такой системы действительно требует понятия ценности информации как инструктирующего фактора. Такое понятие, вообще говоря, не может быть универсальным. Оно должно выражаться в строгих физико-математических терминах применительно к конкретным биологическим процессам. Эйген вводит понятие селективной ценности, характеризующей кинетику матричного синтеза биологических макромолекул. Изложение этой теории и некоторых других вопросов, связанных с понятием ценности информации в биологии, дано в гл

Показатели качества информации

Информация в системе управления является и предметом труда, и продуктом труда, поэтому от ее качества существенно зависят эффективность и качество функционирования системы.

Качество информации можно определить как совокупность свойств, обусловливающих возможность ее использования для удовлетворения определенных в соответствии с ее назначением потребностей.

Рекомендуется выделять следующие основные виды показателей качества промышленной продукции:

□ показатели назначения, характеризующие полезный эффект от использования продукции по назначению и обусловливающие область ее применения;

U показатели надежности и долговечности, характеризующие одноименные е.нойства изделий в конкретных условиях их использования;

L) показатели технологичности, обусловливающие высокую производительность труда при изготовлении и ремонте продукции;

U эргономические показатели, учитывающие комплекс физиологических, психологических, антропометрических параметров человека;

L) эстетические показатели, характеризующие такие свойства продукции, как иi>iразительность, гармоничность, соответствие среде, стилю и т. п.;

U показатели стандартизации и унификации продукции;

U патентно-правовые показатели, характеризующие патентную чистоту изделий и степень его патентной защиты в стране;

U показатели экономические, отражающие затраты на разработку, изготовление и эксплуатацию или потребление продукции, а также экономическую эффективность эксплуатации.

Однако информация — весьма своеобразная, не материальная продукция, поэтому применить к ней в полном объеме данные рекомендации невозможно. Анализируя возможность использования названных видов показателей качества, можно сформулировать систему основных показателей качества экономической информации.

Возможность и эффективность использования информации для управления обусловливается такими ее потребительскими показателями качества, как репрезентативность, содержательность, достаточность, доступность, своевременность, устойчивость, точность, достоверность, актуальность и ценность.

Репрезентативность

Репрезентативность — правильность, качественная адекватность отражения заданных свойств объекта. Репрезентативность информации зависит от правильности ее отбора и формирования. Важнейшее значение при этом приобретают: верность концепции, на базе которой сформулировано исходное понятие, отображаемое показателем; обоснованность отбора существенных признаков и связей отображаемого явления; правильность методики измерения и алгоритма формирования экономического показателя. Нарушение репрезентативности информации приводит нередко к существенным ее погрешностям, называемым чаще всего алгоритмическими.

Содержательность

Содержательность информации — это ее удельная семантическая емкость, равная отношению количества семантической информации в сообщении к объему данных, его отображающих, то есть S = IC/VA. С увеличением содержательности информации растет семантическая пропускная способность информационной системы, так как для передачи одних и тех же сведений требуется преобразовы-иать меньший объем данных. Наряду с содержательностью можно использовать и показатель информативности, характеризующийся отношением количества синтаксической информации (по Шеннону) к объему данных — Y = I/V&. Поскольку в правильно организованных системах управления количество семантической информации пропорционально, а часто и равно количеству синтаксической информации в сообщении, то значение S часто может характеризоваться значением Y.

Достаточность

Достаточность {полнота) экономической информации означает, что она содержит минимальный, но достаточный для принятия правильного управленческого решения набор экономических показателей. Понятие достаточности информации связано с ее смысловым содержанием (семантикой) и прагматикой. Как неполная, то есть недостаточная для принятия правильного решения, так и избыточная информация снижают эффективность управления; наивысшим качеством обладает именно полная информация.

Доступность

Доступность информации для восприятия при принятии управленческого решения обеспечивается выполнением соответствующих процедур ее получения и преобразования. Так, назначением вычислительной системы является увеличение ценности информации путем согласования ее с тезаурусом пользователя, то есть преобразование ее к доступной и удобной для восприятия пользователем форме.

Актуальность

Актуальность информации — это свойство информации сохранять свою полезность (ценность) для управления во времени. Измеряется актуальность A(f) степенью сохранения начальной ценности информации Z(t0) в момент времени t ее использования:

A(t) = Z(t)/Z(t0),

где Z(t) — ценность информации в момент времени t

Актуальность зависит от статистических характеристик отображаемого объекта (от динамики изменения этих характеристик) и от интервала времени, прошедшего с момента возникновения данной информации.

Своевременность

Своевременность — это свойство информации, обеспечивающее возможность ее использования в заданный момент времени. Несвоевременная информация приводит к экономическим потерям и в сфере управления, и в сфере производства. Причиной, обусловливающей экономические потери от несвоевременности в сфере управления, является нарушение установленного режима решения функциональных задач, а иногда и их алгоритмов. Это приводит к увеличению стоимости решения задач вследствие снижения ритмичности, увеличения простоев и сверхурочных работ и т. п. в сфере материального производства. Потери от несвоевременности информации связаны со снижением качества управленческих решений, принятием решения на базе неполной информации или информации некачественной. Своевременной является такая информация, которая может быть учтена при выработке управленческого решения без нарушения регламента, поступающая в систему управления не позже назначенного момента времени.

Точность

Точность информации — это степень близости отображаемого информацией значения и истинного значения данного параметра. Для экономических показателей, отображаемых цифровым кодом, известны четыре классификационных понятия точности:

□ формальная точность, измеряемая значением единицы младшего разряда числа, которым показатель представлен;

□ реальная точность, определяемая значением единицы последнего разряда числа, верность которого гарантируется;

□ достижимая точность — максимальная точность, которую можно получить в данных конкретных условиях функционирования системы;

□ необходимая точность, определяемая функциональным назначением показателя и обеспечивающая правильность принимаемого управленческого решения.

Достоверность

Достоверность информации — свойство информации отражать реально существующие объекты с необходимой точностью. Измеряется достоверность информации доверительной вероятностью необходимой точности, то есть вероятностью того, что отображаемое информацией значение параметра отличается от истинного значения этого параметра в пределах необходимой точности. Наряду с понятием «достоверность информации», существует понятие «достоверность данных», то есть информации, рассматриваемой в синтаксическом аспекте. Под достоверностью данных понимается их безошибочность; измеряемая вероятностью появления ошибок в данных. Недостоверность данных может не повлиять на объем данных, а может даже и увеличить его, в отличие от недостоверности информации, всегда уменьшающей ее количество.

Устойчивость

Устойчивость информации — свойство результатной информации реагировать на изменения исходных данных, сохраняя необходимую точность. Устойчивость информации, как и ее репрезентативность, обусловлена в первую очередь методической правильностью ее отбора и формирования.

Ценность

Ценность экономической информации — комплексный показатель ее качества, ее мера на прагматическом уровне. Ценность экономической информации определяется эффективностью осуществляемого на ее основе экономического управления.

Успешное внедрение информационных технологий связано с возможностью их типизации. Конкретная информационная технология обладает комплексным составом компонентов, поэтому целесообразно определить ее структуру и состав.

Конкретная информационная технология определяется в результате компиляции и синтеза базовых технологических операций, специализированных технологий и средств реализации.

Технологический процесс - часть информационного процесса, содержащая действия (физические, механические и др.) по изменению состояния информации.

Информационная технология базируется на реализации информационных процессов, разнообразие которых требует выделения базовых, характерных для любой информационной технологии.

Базовый технологический процесс основан на использовании стандартных моделей и инструментальных средств и может быть использован в качестве составной части информационной технологии. К их числу можно отнести: операции извлечения, транспортировки, хранения, обработки и представления информации.

Среди базовых технологических процессов выделим:

извлечение информации;

транспортирование информации;

обработку информации;

хранение информации;

представление и использование информации.

Процесс извлечения информации связан с переходом от реального представления предметной области к его описанию в формальном виде и в виде данных, которые отражают это представление.

В процессе транспортирования осуществляют передачу информации на расстояние для ускоренного обмена и организации быстрого доступа к ней, используя при этом различные способы преобразования.

Процесс обработки информации состоит в получении одних «информационных объектов» из других «информационных объектов», путем выполнения некоторых алгоритмов; он является одной из основных операций, выполняемых над информацией и главным средством увеличения ее объема и разнообразия.

Процесс хранения связан с необходимостью накопления и долговременного хранения данных, обеспечением их актуальности, целостности, безопасности, доступности.

Процесс представления и использования информации направлен на решение задачи доступа к информации в удобной для пользователя форме.

Базовые информационные технологии строятся на основе базовых технологических операций, но кроме этого включают ряд специфических моделей и инструментальных средств. Этот вид технологий ориентирован на решение определенного класса задач и используется в конкретных технологиях в виде отдельной компоненты. Среди них можно выделить:

мультимедиа-технологии;

геоинформационные технологии;

технологии защиты информации;

CASE-технологии;

телекоммуникационные технологии;

технологии искусственного интеллекта.

Специфика конкретной предметной области находит отражение в специализированных информационных технологиях, например, организационное управление, управление технологическими процессами, автоматизированное проектирование, обучение и др. Среди них наиболее продвинутыми являются следующие информационные технологии:

организационного управления (корпоративные информационные технологии);

в промышленности и экономике;

в образовании;

автоматизированного проектирования.

Аналогом инструментальной базы (оборудование, станки, инструмент) являются средства реализации информационных технологий, которые можно разделить на методические, информационные, математические, алгоритмические, технические и программные.

CASE-технология (Computer Aided Software Engineering - Компьютерное Автоматизированное Проектирование Программного обеспечения) является своеобразной «технологической оснасткой», позволяющей осуществить автоматизированное проектирование информационных технологий.

Методические средства определяют требования при разработке, внедрении и эксплуатации информационных технологий, обеспечивая информационную, программную и техническую совместимость. Наиболее важными из них являются требования по стандартизации.

Информационные средства обеспечивают эффективное представление предметной области, к их числу относятся информационные модели, системы классификации и кодирования информации (общероссийские, отраслевые) и др.

Математические средства включают в себя модели решения функциональных задач и модели организации информационных процессов, обеспечивающие эффективное принятие решения. Математические средства автоматически переходят в алгоритмические, обеспечивающие их реализацию.

Технические и программные средства задают уровень реализации информационных технологий как при их создании, так и при их реализации.

Таким образом, конкретная информационная технология определяется в результате компиляции и синтеза базовых технологических операций, отраслевых технологий и средств реализации.

studopedia.ru

Как определяется количество информации представленных с помощью знаковых систем?

Alexey khoroshev

Определение количества информации, представленной с помощью знаковых систем

Если рассматривать символы алфавита как множество возможных сообщений (событий) N, то количество информации, которое несет один знак можно определить из формулы 2.1

где I – количество информации,

N – количество возможных событий,

pi- вероятности отдельных событий.

Если считать появление каждого знака алфавита в тексте событиями равновероятными, то для определения количества информации можно воспользоваться формулой 2.2(I = log2N ) или уравнением 2.3.(N = 2I ).

Количество информации, которое несет один знак алфавита тем больше, чем больше знаков входят в этот алфавит, т. е. чем больше мощность алфавита.

Количество информации, содержащейся в сообщении, закодированном с помощью знаковой системы, равно количеству информации, которое несет один знак, умноженному на число знаков в сообщении.

Пример 2.5. Какова мощность алфавита, с помощью которого записано сообщение, содержащее 2048 символов, если его объем составляет 1,25 Кбайта.

С помощью программы VersaVerter или арифметически перевести информационный объем сообщения в биты:

.I = 10 240 бит

Определить количество бит, приходящееся на один символ:

10 240 бит : 2 048 = 5 бит

По формуле 2.3 определить количество символов в алфавите:

N = 2I = 25 = 32

Читайте также

![Российский законодатель дает определения понятию информация Российский законодатель дает определения понятию информация]() Российский законодатель дает определения понятию информация

Российский законодатель дает определения понятию информация![Акт определение Акт определение]() Акт определение

Акт определение- Дать определение понятию индустриализация

![Дайте определение понятию авария Дайте определение понятию авария]() Дайте определение понятию авария

Дайте определение понятию авария![Болезнь определение Болезнь определение]() Болезнь определение

Болезнь определение![Определение высоты объекта Определение высоты объекта]() Определение высоты объекта

Определение высоты объекта![Легальное определение юридического лица дано Легальное определение юридического лица дано]() Легальное определение юридического лица дано

Легальное определение юридического лица дано![Деталь определение Деталь определение]() Деталь определение

Деталь определение![Закон джоуля ленца формула и определение Закон джоуля ленца формула и определение]() Закон джоуля ленца формула и определение

Закон джоуля ленца формула и определение![Двигатель определение Двигатель определение]() Двигатель определение

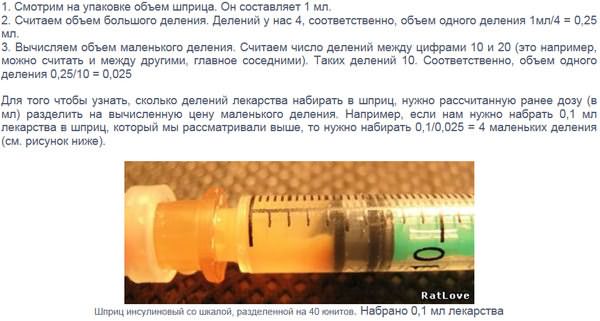

Двигатель определение![Определение цены деления шприца Определение цены деления шприца]() Определение цены деления шприца

Определение цены деления шприца![Места массового скопления людей определение Места массового скопления людей определение]() Места массового скопления людей определение

Места массового скопления людей определение

Российский законодатель дает определения понятию информация

Российский законодатель дает определения понятию информация Акт определение

Акт определение Дайте определение понятию авария

Дайте определение понятию авария Болезнь определение

Болезнь определение Определение высоты объекта

Определение высоты объекта Легальное определение юридического лица дано

Легальное определение юридического лица дано Деталь определение

Деталь определение Закон джоуля ленца формула и определение

Закон джоуля ленца формула и определение Двигатель определение

Двигатель определение Определение цены деления шприца

Определение цены деления шприца Места массового скопления людей определение

Места массового скопления людей определение