Тема: Подходы к понятию информации и измерению информации

Тема 2.1 Занятие №6

Термин информация происходит от латинского information, что означает разъяснение, осведомление, изложение.

В широком смысле информация– это общенаучное понятие, включающее в себя обмен сведениями между людьми, обмен сигналами между живой и неживой природой, людьми и устройствами.

Информация– это сведения об объектах и явлениях окружающей среды, их параметрах, свойствах и состоянии, которые уменьшают имеющуюся о них степень неопределенности, неполноты знаний.

Наряду с информацией в информатике часто употребляется понятие данные.

Данные могут рассматриваться как признаки или записанные наблюдения, которые по каким-то причинам не используются, а только хранятся. В том случае, если появляется возможность использовать эти данные для уменьшения неопределенности о чем-либо, данные превращаются в информацию. Поэтому можно утверждать, что информацией являются используемые данные.

С точки зрения информатики наиболее важными являются следующие свойства информации:

|

|

Информация достоверна, если она отражает истинное положение дел. Недостоверная информация может привести к неправильному пониманию или принятию неправильных решений.

Достоверная информация со временем может стать недостоверной, так как она обладает свойством устаревать, то есть перестаёт отражать истинное положение дел.

Информация полна, если её достаточно для понимания и принятия решений. Как неполная, так и избыточная информация сдерживает принятие решений или может повлечь ошибки.

Точность информации определяется степенью ее близости к реальному состоянию объекта, процесса, явления и т.п.

Ценность информации зависит от того, насколько она важна для решения задачи, а также от того, насколько в дальнейшем она найдёт применение в каких-либо видах деятельности человека.

Только своевременно полученная информация может принести ожидаемую пользу. Одинаково нежелательны как преждевременная подача информации (когда она ещё не может быть усвоена), так и её задержка.

Если ценная и своевременная информация выражена непонятным образом, она может стать бесполезной.

Информация становится понятной, если она выражена языком, на котором говорят те, кому предназначена эта информация.

Информация должна преподноситься в доступной (по уровню восприятия) форме. Поэтому одни и те же вопросы, по разному излагаются в школьных учебниках и научных изданиях.

Информацию по одному и тому же вопросу можно изложить кратко (сжато, без несущественных деталей) или пространно (подробно, многословно). Краткость информации необходима в справочниках, энциклопедиях, учебниках, всевозможных инструкциях.

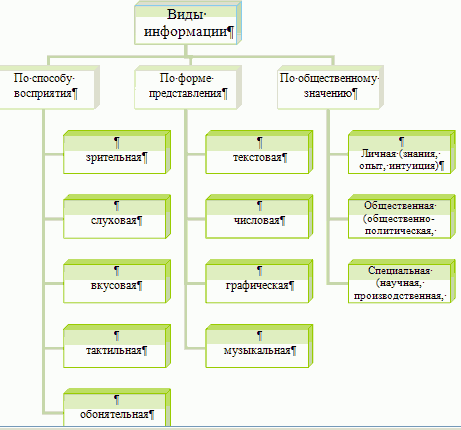

Виды информации.Говорить об информации вообще, а не применительно к какому-то ее конкретному виду (роду, типу, классу) беспредметно.

Какие типы или виды информации можно выделить?

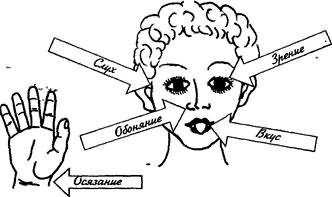

Во-первых, по способу восприятия информации.

У человека пять органов чувств:

- зрение; с помощью глаз люди различают цвета, воспринимают зрительную информацию, к которой относятся и текстовая, и числовая, и графическая;

- слух; уши помогают воспринимать звуковую информацию – речь, музыку, звуковые сигналы, шум;

- обоняние; с помощью носа люди получают информацию о запахах окружающего мира;

- вкус; вкусовые рецепторы языка дают возможность получить информацию о том, каков предмет на вкус – горький, кислый, сладкий, соленый;

- осязание; кончиками пальцев (или просто кожей), на ощупь можно получить информацию о температуре предмета – горячий он или холодный, о качестве его поверхности – гладкий или шершавый.

Человек получает информацию о внешнем мире с помощью своих органов чувств. Практически около 90% информации человек получает при помощи органов зрения (визуальный), примерно 9% – при помощи органов слуха (аудиальный) и только 1% при помощи остальных органов чувств (обоняния, вкуса, осязания).

Во-вторых, по форме представления информации.

Рассмотрим только те виды информации, которые “понимают” технические устройства (в частности, компьютер).

Текстовая информация, например текст в учебнике, сочинение в тетради, реплика актера в спектакле, прогноз погоды, переданный по радио. Заметим, что в устном общении (личная беседа, разговор по телефону, радиопостановка спектакля) информация может быть представлена только в словесной, текстовой форме. Числовая информация, например таблица умножения, арифметический пример, счет в хоккейном матче, время прибытия поезда и др. В чистом виде числовая информация встречается редко, разве что на контрольных по математике. Чаще всего используется комбинированная форма представления информации.

- Рассмотрим пример. Вы получили телеграмму: “Встречайте двенадцатого. Поезд прибывает в восемь вечера”. В данном тексте слова “двенадцатого” и “восемь” мы понимаем как числа, хотя они и выражены словами.

Графическая информация: рисунки, схемы, чертежи, фотографии. Такая форма представления информации наиболее доступна, так как сразу передает необходимый образ (модель), а словесная и числовая требуют мысленного воссоздания образа. В то же время графическая форма представления не дает исчерпывающих разъяснений о передаваемой информации. Поэтому наиболее эффективно сочетание текста, числа и графики.

- Например, при решении задач по геометрии мы используем чертеж (графика) + пояснительный текст (текст) + числовые расчеты (числа).

Музыкальная (звуковая) информация.

В настоящее время мультимедийная (многосредовая, комбинированная) форма представления информации в вычислительной техники становится основной. Цветная графика сочетается в этих системах со звуком и текстом, с движущимися видеоизображением и трехмерными образами.

В-третьих, по общественному значению информации.

Информация может быть:

- личной – это знания, опыт, интуиция, умения, эмоции, наследственность конкретного человека;

- общественной – общественно-политическая, научно-популярная, т. е. то, что мы получаем из средств массовой информации. Кроме того, это опыт всего человечества, исторические, культурные и национальные традиции и др.;

- обыденная – та, которой мы обмениваемся в процессе общения;

- эстетическая – изобразительное искусство, музыка, театр и др.;

- специальная – научная, производственная, техническая, управленческая.

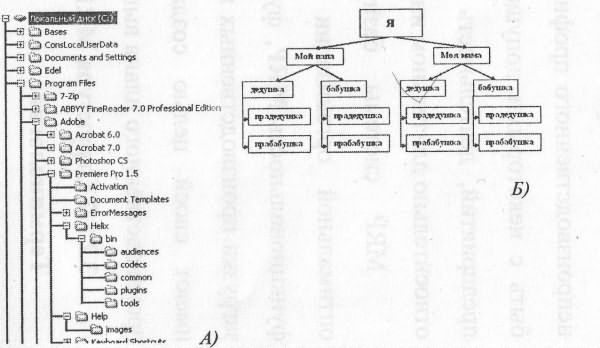

Представим все рассмотренные виды информации в виде схемы:

В зависимости от типа носителя различают следующие виды информации:

· документальную;

· акустическую (речевую);

· телекоммуникационную.

Документальная информация представляется в графическом или буквенно-цифровом виде на бумаге, а также в электронном виде на магнитных и других носителях.

Речевая информация возникает в ходе ведения разговоров, а также при работе систем звукоусиления и звуковоспроизведения. Носителем речевой информации являются звуковые колебания в диапазоне частот от 200…300 Гц до 4…6 кГц.

Телекоммуникационная информация циркулирует в технических средствах обработки и хранения информации, а также в каналах связи при ее передаче. Носителем информации при ее обработке техническими средствами и передаче по проводным каналам связи является электрический ток, а при передаче по радио- и оптическому каналам – электромагнитные волны.

Источник информации может вырабатывать непрерывное сообщение (сигнал), в этом случае информация называется непрерывной, или дискретной – информация называется дискретной.

Например, сигналы, передаваемые по радио и телевидению, а также используемые в магнитной записи, имеют форму непрерывных, быстро изменяющихся во времени зависимостей. Такие сигналы называются непрерывными, или аналоговыми сигналами. В противоположность этому в телеграфии и вычислительной технике сигналы имеют импульсную форму и называются дискретными сигналами.

Сравнивая непрерывную и дискретную формы представления информации, нетрудно заметить, что при использовании непрерывной формы для создания вычислительной машины потребуется меньшее число устройств (каждая величина представляется одним, а не несколькими сигналами), но эти устройства будут сложнее (они должны различать значительно большее число состояний сигнала).

Информация, циркулирующая в обществе, требует специальных средств и методов обработки, хранения и использования. Сформировались новые научные дисциплины – кибернетика, бионика, робототехника и другие, имеющие своей целью изучение закономерностей информационных процессов.

Существует три подхода к измерению информации:

I подход– Неизмеряемость информации в быту (информация как новизна).

II подход– Технический или объемный (информация как сообщения в форме знаков или сигналов, хранимые, перерабатываемые и обрабатываемые с помощью технических устройств).

В вычислительной технике применяются две стандартные единицы измерения информации: бит и байт. Поскольку компьютер предназначен для обработки больших объемов информации, то используют производные единицы – килобайт (Кб), мегабайт (Мб), гигабайт (Гб). Обычно приставка «кило» означает тысячу, а приставка «мега»– миллион. Но в вычислительной технике осуществляется привязка к принятой двоичной системе кодирования.

В силу этого один килобайт равен не 1000 байтов, а 210 = 1024 байта.

Аналогично, 1 Мб = 210 Кб = 1024 Кб = 220 байтов = 1 048 576 байтов.

1 Гб = 210 Мб = 1024 Мб = 220 Кб = 230 байтов = 1 073 741 824 байта.

III подход– Вероятностный. Измерение информации в теории информации (информация как снятая неопределенность).

Получение информации (ее увеличение) означает увеличение знания, что, в свою очередь, означает уменьшение незнания или информационной неопределенности.

За единицу количества информации принимают выбор одного из двух равновероятных сообщений («да» или «нет», «1» или «0»). Она также названа битом.

studopedia.ru

7.2. Подходы к измерению информации

Подходы к раскрытию темы в учебной литературе

Проблема измерения информации напрямую связана с проблемой определения информации, поскольку сначала надо уяснить, ЧТО собираемся измерять, а потом уже — КАК это делать, какие единицы использовать. Если опираться на расплывчатое, интуитивное представление ученика об информации, то невозможно дать сколько-нибудь логичное определение количества информации, ввести единицы ее измерения.

Характерным приемом для ряда учебников является следующий: обсуждая вопрос об измерении информации, тут же переходят к описанию компьютерного представления информации в форме двоичного кода. Затем дается утверждение о том, что количество информации равно количеству двоичных цифр (битов) в таком коде. Вот цитата из учебника [16]: «В современной вычислительной технике информация чаще всего кодируется с помощью последовательностей сигналов всего двух видов: намагничено или не намагничено, включено или выключено, высокое или низкое напряжение и т.д. Принято обозначать одно состояние цифрой 0, а другое — цифрой 1. Такое кодирование называется двоичным кодированием, а цифры 0 и 1 называются битами (от англ. Bit— binarydigit— двоичная цифра)». В следующем параграфе сказано: «А как узнать количество информации в сообщении, в каких единицах эту информацию измерять? Для двоичных сообщений в качестве такой числовой меры используется количество бит в сообщении. Это количество называется информационным объемом сообщения».

В учебнике [5] написано: «Чтобы стандартизировать измерение количества информации, договорились за единицу количества информации принять сообщение, состоящее из одного символа двухсимвольного алфавита. Использование для измерения количества информации алфавитов с другим числом символов можно уподобить переходу к более крупным единицам измерения». В этом же учебнике содержатся рассуждения и о другом подходе к представлению о количестве информации — содержательном, семантическом: «Количество информации, получаемой из сообщения, зависит от имеющихся предварительных знаний».

Вопрос об измерении информации необходимо раскрывать в контексте рассматриваемого подхода к определению информации. Здесь обязательно должна присутствовать логическая последовательность, пусть даже она приводит в тупик.

В учебнике [26] последовательно прослеживаются два подхода к измерению информации: с точки зрения содержательной и кибернетической концепций.

Методические рекомендации по изучению темы

Содержательный подход к измерению информации

Изучаемые вопросы:

От чего зависит информативность сообщения, принимаемого человеком.

Единица измерения информации.

Количество информации в сообщении об одном из 7V равновероятных событий.

С позиции содержательного подхода просматривается следующая цепочка понятий: информация — сообщение — информативность сообщения — единица измерения информации — информационный объем сообщения.

Исходная посылка: информация — это знания людей. Следующий вопрос: что такое сообщение? Сообщение — это информационный поток, который в процессе передачи информации поступает к принимающему его субъекту. Сообщение — это и речь, которую мы слушаем (радиосообщение, объяснение учителя), и воспринимаемые нами зрительные образы (фильм по телевизору, сигнал светофора), и текст книги, которую мы читаем и т.д.

Вопрос об информативности сообщения следует обсуждать на примерах, предлагаемых учителем и учениками. Правило: информативным назовем сообщение, которое пополняет знания человека, т. е. несет для него информацию. Для разных людей одно и то же сообщение, с точки зрения его информативности, может быть разным. Если сведения «старые», т. е. человек это уже знает, или содержание сообщения непонятно человеку, то для него это сообщение неинформативно. Информативно то сообщение, которое содержит новые и понятные сведения.

Нельзя отождествлять понятия «информация» и «информативность сообщения». Следующий пример иллюстрирует различие понятий. Вопрос: «Содержит ли информацию вузовский учебник по высшей математике с точки зрения первоклассника?». Ответ: «Да, содержит с любой точки зрения! Потому что в учебнике заключены знания людей: авторов учебника, создателей математического аппарата (Ньютона, Лейбница и др.), современных математиков». Эта истина — абсолютна. Другой вопрос: «Будет ли информативным текст этого учебника для первоклассника, если он попытается его прочитать? Иначе говоря, может ли первоклассник с помощью этого учебника пополнить собственные знания?» Очевидно, что ответ отрицательный. Читая учебник, т.е. получая сообщения, первоклассник ничего не поймет, а стало быть, не обратит его в собственные знания.

При объяснении этой темы можно предложить ученикам поиграть в своеобразную викторину. Например, учитель предлагает детям перечень вопросов, на которые они молча записывают ответы на бумагу. Если ученик не знает ответа, он ставит знак вопроса. После этого учитель дает правильные ответу на свои вопросы, а ученики, записав ответы учителя, отмечают, какие из них оказались для них информативными (+), какие — нет (—). При этом для сообщений, отмеченных минусом, нужно указать причину отсутствия информации: не новое (это я знаю), непонятное. Например, список вопросов и ответы одного из учеников могут быть следующими.

|

Вопрос учителя |

Ответ ученика |

Информативность сообщения |

Причина неинформативности |

|

|

1. Какой город является столицей Франции |

Столица Франции — Париж |

Столица Франции — Париж |

— |

Не новое |

|

2.4-го изучает коллоидная химия |

9 |

Коллоидная химия изучает дисперсионные состояния систем, обладающих высокой степенью раздробленности |

— |

Непонятное |

|

3. Какую высоту и вес имеет Эйфелева башня? |

9 |

Эйфелева башня имеет высоту 300 метров и вес 9000 тонн. |

+ |

Введение понятия «информативность сообщения» является первым подходом к изучению вопроса об измерении информации в рамках содержательной концепции. Если сообщение неинформативно для человека, то количество информации в нем, с точки зрения этого человека, равно нулю. Количество информации в информативном сообщении больше нуля.

Для определения количества информации нужно ввести единицу измерения информации. В рамках содержательного подхода такая единица должна быть мерой пополнения знаний субъекта; иначе можно еще сказать так: мерой уменьшения степени его незнания. В учебнике [26] дано следующее определение единицы информации: «Сообщение, уменьшающее неопределенность знаний в 2 раза, несет 1 бит информации». Немного дальше приводится определение для частного случая: «Сообщение о том, что произошло одно событие из двух равновероятных, несет 1 бит информации».

Определение бита — единицы измерения информации может оказаться сложным для понимания учениками. В этом определении содержится незнакомое детям понятие «неопределенность знаний». Прежде всего нужно раскрыть его. Учитель должен хорошо понимать, что речь идет об очень частном случае: о сообщении, которое содержит сведения о том, что произошло одно из конечного множества (N) возможных событий. Например, о результате бросания монеты, игрового кубика, вытаскивания экзаменационного билета и т. п. Неопределенность знания о результате некоторого события — это число возможных вариантов результата: для монеты — 2, для кубика — 6, для билетов — 30 (если на столе лежало 30 билетов).

Еще одной сложностью является понятие равновероятности. Здесь следует воспользоваться интуитивным представлением детей, подкрепив его примерами. События равновероятны, если ни одно из них не имеет преимущества перед другими. С этой точки зрения выпадения орла и решки — равновероятны; выпадения каждой из шести граней кубика — равновероятны. Полезно привести примеры и неравновероятных событий. Например, в сообщении о погоде в зависимости от сезона сведения о том, что будет дождь или снег могут иметь разную вероятность. Летом наиболее вероятно сообщение о дожде, зимой — о снеге, а в переходный период (в марте или ноябре) они могут оказаться равновероятными. Понятие «более вероятное событие» можно пояснить через родственные понятия: более ожидаемое, происходящее чаще в данных условиях. В рамках базового курса не ставится задача понимания учениками строгого определения вероятности, умения вычислять вероятность. Но представление о равновероятных и неравновероятных событиях должно быть ими получено. Ученики должны научиться приводить примеры равновероятных и неравновероятных событий.

При наличии учебного времени полезно обсудить с учениками понятия «достоверное событие» — событие, которое обязательно происходит, и «невозможное событие». От этих понятий можно оттолкнуться, чтобы ввести интуитивное представление о мере вероятности. Достаточно сообщить, что вероятность достоверного события равна 1, а невозможного — 0. Это крайние значения. Значит, во всех других «промежуточных» случаях значение вероятности лежит между нулем и единицей. В частности, вероятность каждого из двух равновероятных событий равна ![]() . При углубленном варианте изучения базового курса можно использовать материал, приведенный в подразделе 1.1 «Вероятность и информация» второй части учебника [26].

. При углубленном варианте изучения базового курса можно использовать материал, приведенный в подразделе 1.1 «Вероятность и информация» второй части учебника [26].

Возвращаясь к вопросу об измерении количества информации, заключенной в сообщении об одном из N равновероятных событий, предлагаем следующую логическую цепочку раскрытия темы.

Объяснение удобно начать с частного определения бита как меры информации в сообщении об одном из двух равновероятных событий. Обсуждая традиционный пример с монетой (орел — решка), следует отметить, что получение сообщения о результате бросания монеты уменьшило неопределенность знаний в два раза: перед подбрасыванием монеты было два равновероятных варианта, после получения сообщения о результате остался один единственный. Далее следует сказать, что и для всех других случаев сообщений о равновероятных событиях при уменьшении неопределенности знаний в два раза передается 1 бит информации.

Примеры, приведенные в учебнике, учитель может дополнить другими, а также предложить ученикам придумать свои примеры. Индуктивно, от частных примеров учитель вместе с классом приходит к обобщенной формуле: 2i = N. Здесь N — число вариантов равновероятных событий (неопределенность знаний), а i — количество информации в сообщении о том, что произошло одно из N событий.

Если N— известно, а i является неизвестной величиной, то данная формула превращается в показательное уравнение. Как известно, показательное уравнение решается с помощью функции логарифма: i= log2N. Здесь учителю предоставляются два возможных пути: либо с опережением уроков математики объяснить, что такое логарифм, либо «не связываться» с логарифмами. Во втором варианте следует рассмотреть с учениками решение уравнения для частных случаев, когда N есть целая степень двойки: 2, 4, 8, 16, 32 и т.д. Объяснение происходит по схеме:

Если N = 2 = 21, то уравнение принимает вид: 2i = 21, отсюда i = 1.

Если N = 4 = 22, то уравнение принимает вид: 21 = 22, отсюда i= 2.

Если N = 8 = 23, то уравнение принимает вид: 2i = 23, отсюда i = 3 и т. д.

В общем случае, если N = 2k, где k— целое число, то уравнение принимает вид 2i = 2kи, следовательно, i = k. Ученикам полезно запомнить ряд целых степеней двойки хотя бы до 210 = 1024. С этими величинами им предстоит еще встретиться в других разделах.

Для тех значений N, которые не являются целыми степенями двойки, решение уравнения 2i = N можно получать из приведенной в учебнике [26] таблицы в §2. Совсем не обязательно говорить ученикам, что это таблица логарифмов по основанию 2. Например, желая определить, сколько же бит информации несет сообщение о результате бросания шестигранного кубика, нужно решать уравнение: 2i = 6. Поскольку 22 < 6 < 23, то следует пояснить ученикам, что 2 < i < 3. Заглянув в таблицу, узнаем (с точностью до пяти знаков после запятой), что i = 2,58496 бит.

Рассмотренные примеры исчерпывают возможности содержательного подхода в решении проблемы измерения информации. Очевидно, что предложенный метод применим только в очень частных случаях. Попробуйте с содержательной точки зрения подсчитать количество информации, полученной в результате прочтения нового для вас параграфа в учебнике! Сделать это невозможно, хотя фактом является то, что информация получена. В этом и проявляется тот «тупик» данного подхода, о котором говорилось выше.

Кибернетический (алфавитный) подход к измерению информации

Изучаемые вопросы:

Что такое алфавит, мощность алфавита.

Что такое информационный вес символа в алфавите.

Как измерить информационный объем текста с алфавитной точки зрения.

Что такое байт, килобайт, мегабайт, гигабайт.

Скорость информационного потока и пропускная способность канала.

Рассматриваемый в этой теме подход к измерению информации является альтернативным к содержательному подходу, обсуждавшемуся ранее. Здесь речь идет об измерении количества информации в тексте (символьном сообщении), составленном из символов некоторого алфавита. К содержанию текста такая мера информации отношения не имеет. Поэтому такой подход можно назвать объективным, т.е. не зависящим от воспринимающего его субъекта.

Алфавитный подход — это единственный способ измерения информации, который может применяться по отношению к информации, циркулирующей в информационной технике, в компьютерах.

Опорным в этой теме является понятие алфавита. Алфавит — это конечное множество символов, используемых для представления информации. Число символов в алфавите называется мощностью алфавита (термин взят из математической теории множеств). В основном содержании базового курса алфавитный подход рассматривается лишь с позиции равновероятного приближения. Это значит, что допускается предположение о том, что вероятности появления всех символов алфавита в любой позиции в тексте одинаковы. Разумеется, это не соответствует реальности и является упрощающим предположением.

В рассматриваемом приближении количество информации, которое несет в тексте каждый символ (i), вычисляется из уравнения Хартли: 2i = N, где N — мощность алфавита. Величину i можно назвать информационным весом символа. Отсюда следует, что количество информации во всем тексте (i), состоящем из К символов, равно произведению информационного веса символа на К: I= iК. Эту величину можно назвать информационным объемом текста. Такой подход к измерению информации еще называют объемным подходом.

Полезно обсудить с учениками следующий вопрос: какова минимальная мощность алфавита, с пoмощыо которого можно записывать (кодировать) информацию? Этот вопрос напрямую связан с заданием № 3 к § 3 учебника [11], которое звучит так: «Докажите, что исходя из алфавитного подхода, сообщение любой длины, использующее односимвольный алфавит, содержит нулевую информацию».

Предположим, что используемый алфавит состоит всего из одного символа, например «1». Интуитивно понятно, что сообщить что-либо с помощью единственного символа невозможно. Но это же доказывается строго с точки зрения алфавитного подхода. Информационный вес символа в таком алфавите находится из уравнения: 2i= 1. Но поскольку 1 = 2°, то отсюда следует, что i = 0 бит. Полученный вывод можно проиллюстрировать следующим образным примером. Представьте себе толстую книгу в 1000 страниц, на всех страницах которой написаны одни единицы (единственный символ используемого алфавита). Сколько информации в ней содержится? Ответ: нисколько, ноль. Причем такой ответ получается с любой позиции, как с содержательной, так и с алфавитной.

Минимальная мощность алфавита, пригодного для передачи информации, равна 2. Такой алфавит называется двоичным алфавитом. Информационный вес символа в двоичном алфавите легко определить. Поскольку 2i = 2, то i = 1 бит. Итак, один символ двоичного алфавита несет 1 бит информации. С этим обстоятельством ученики снова встретятся, когда будут знакомиться с алфавитом внутреннего языка компьютера — языка двоичного кодирования.

Бит — основная единица измерения информации. Кроме нее используются и другие единицы. Следует обратить внимание учеников на то, что в любой метрической системе существуют единицы основные (эталонные) и производные от них. Например, основная физическая единица длины — метр. Но существуют миллиметр, сантиметр, километр. Расстояния разного размера удобно выражать через разные единицы. Так же обстоит дело и с измерением информации. 1 бит — это исходная единица. Следующая по величине единица — байт. Байт вводится как информационный вес символа из алфавита мощностью 256. Поскольку 256 = 28, то 1 байт = 8 бит. Мы снова встречаемся с темой, которая является своеобразной пропедевтикой к будущему изучению компьютера.

Уже в рамках данной темы можно сообщить ученикам, что компьютер для внешнего представления текстов и другой символьной информации использует алфавит мощностью 256 (во внутреннем представлении любая информация в компьютере кодируется в двоичном алфавите). Фактически, для выражения объема компьютерной информации в качестве основной единицы используется байт.

Представляя ученикам более крупные единицы: килобайт, мегабайт, гигабайт — нужно обратить их внимание на то, что мы привыкли приставку «кило» воспринимать, как увеличение в 1000 раз. В информатике это не так. Килобайт больше байта в 1024 раза, а число 1024 = 210. Так же относится и «мега» по отношению к «кило» и т.д. Тем не менее часто при приближенных вычислениях используют коэффициент 1000.

В рамках углубленного курса учитель может изложить алфавитный подход в более адекватном варианте, без допущения равновероятности символов. Теоретический и практический материал на эту тему можно найти в пособии [8] в подразделе 1.4.

StudFiles.ru

Алгоритмический, семантический и ценностный подходы к определению информации

Классическая теория информации Шеннона не может охватить всего многообразия понятия информации и, в первую очередь, ее содержательного аспекта. Теория информации К. Шеннона также не занимается определением ценности информации, так как её интересуют лишь проблемы передачи данных оптимальным образом.

Наряду с энтропийным (синтаксическим) подходом Шеннона к определению информации существуют и другие, среди которых следует отметить алгоритмический, семантический и прагматический (ценностный) подходы.

Идея алгоритмического измерения количества информации была выдвинута в 1965 г. А.Н. Колмогоровым. Суть ее заключается в том, что количество информации определяется как минимальная длина программы, позволяющей преобразовать один объект (множество) в другой. Чем больше различаются два объекта между собой, тем сложнее (длиннее) программа перехода от одного объекта к другому. Так, воспроизвести последовательность букв а, а,...,а можно при помощи очень простой программы. Несколько большей окажется длина программы, восстанавливающей последовательность а, в, с, а, в, с,...Длина программы при этом измеряется количеством команд (операций), позволяющих воспроизвести заданную последовательность. Этот подход, не базирующийся на понятии вероятности, позволяет, например, определить прирост количества информации, содержащейся в результатах расчета, по сравнению с исходными данными. Вероятностный подход Шеннона в теории информации не может дать ответа на подобные вопросы.

Попытки оценить не только количественную, но и содержательную сторону информации дали толчок к дразвитию семантической (смысловой) теории информации. Исследования в этой области теснее всего связаны с семиотикой – теорией знаковых систем. Семиотика исследует знаки как особый вид носителей информации. При этом знаком является условное изображение элемента сообщения, словом – совокупность знаков, имеющих смысловое значение, языком – словарь и правила пользования им. Таким образом, рассуждая о количестве, содержании и ценности информации, заключённой в сообщении, можно исходить из возможностей анализа знаковых структур.

В качестве знаковых систем используются естественные и искусственные языки, в том числе и языки программирования, различные системы сигнализации, логические, математические и химические символы. Сразу же заметим, что методы точного количественного определения смыслового содержания информации до настоящего времени еще не разработаны.

Рассматривая знаковые системы, выделяют три основных аспекта их изучения: синтактику, семантику и прагматику. Синтактика изучает синтаксис знаковых структур, т.е. способы сочетаний знаков, правила образования этих сочетаний и их преобразований безотносительно к их значениям. Отметим, что рассмотренные ранее способы определения количества информации можно отнести к синтаксическим способам.

Семантикаизучает знаковые системы как средства выражения смысла, определенного содержания, т.е. правила интерпретации знаков и их сочетаний, смысловую сторону языка.

Прагматикарассматривает соотношение между знаковыми системами и их пользователями, или приемниками-интерпретаторами сообщений. Иными словами, к прагматике относится изучение практической полезности знаков, слов и, следовательно, сообщений, т.е. потребительский аспект изучения языка.

Ценностный подход к определению количества информации представлен в работах М.М. Бонгарда, А.А. Харкевича, В.И. Корогодина, Д.С. Чернавского.

Д.С. Чернавский придерживается следующего определения информации: «Информация - это запомненный выбор одного варианта из нескольких возможных и равноправных». Это определение является развитием подхода, предложенного Г. Кастлером.

Комментарий. Определение Кастлера начинается словами «случайный изапомненный выбор». Однако, как отмечает Д.С. Чернавский, выбор может быть сделан и неслучайным образом. Кроме этого, выбор должен быть обязательно запомнен. Запоминание означает, что сделанный выбор сохраняется в течение времени, которое больше, чем характерное время использования информации. Равноправие вариантов означает, что априорные различия между ними невелики. Равноправие выборов не означает их равновероятности, но означает, что вероятности вариантов это величины одного порядка.

Если выбор сделан случайным образом - говорят о генерации информации, если выбор неслучаен, продиктован «сверху» – это рецепция информации. Рецепция – выбор навязанный системе. Это означает перевод системы из одного состояния в другое, определённое состояние. Рецепция часто встречается в технике, когда некоторую динамическую систему переводят в нужное состояние путём воздействия на неё электрическим или световым импульсом. В этом случае говорят о силовом переключении. Существует параметрическое переключение, когда перевод системы в нужное состояние осуществляется путём изменения её параметров. Такой способ переключения чаще встречается в биологических системах. Процесс обучения «учитель – ученик» основан на рецепции информации: обучаемый воспринимает некоторую информацию, которую передаёт ему учитель. Генерация информации более «творческий» процесс – его результат заранее непредсказуем.

Результат рецепции или генерации зависит от информации, которая уже воспринята и содержится в генераторе или рецепторе, т.е. новые выборы можно сделать только на основе выборов, сделанных ранее. В связи с этим можно ввести понятие тезауруса. Тезаурус - информация, содержащаяся в системе на данном уровне, необходимая для рецепции или генерации информации на следующем уровне. Без тезауруса нет множества, из которого нужно сделать выбор. Каждый раз, когда мы воспринимаем или генерируем информацию, нам необходимы некоторые знания (язык, математика, история, биология и т.п.), которые и составляют наш тезаурус. Поэтому студенты, слушающие лекцию в одной аудитории, воспринимают разную информацию, а кто-то вообще её не воспринимает, в силу разного тезауруса, которым они обладают на данный момент времени.

Запоминание сделанного выбора играет важную роль. Запомненный выбор называют макроинформацией. Если выбор не запоминается, то фиксации информации не происходит – такой выбор называется микроинформацией. Микроинформация встречается в физических системах с большим числом состояний; при этом спонтанный переход большого числа частиц из одного состояния в другое совершается в течение малого отрезка времени t = 10-13 с. Именно поэтому, термодинамическая трактовка информации для таких систем некорректна – термодинамическая система не запоминает «сделанный выбор». Здесь мы имеем дело с микроинформацией. Свойство запоминания присуще лишь макросистемам, которые могут сохранять выбранное состояние достаточно долгий период времени. Таким простейшим запоминающим устройством является триггер – система с двумя устойчивыми состояниями. Переход из одного состояния в другое происходит не спонтанно, а в результате внешнего воздействия – происходит рецепция информации. Вывод: нельзя путать Больцмановскую энтропию с информационной энтропией.

На начальном этапе своего развития информатика занималась преимущественно проблемами передачи и хранения информации. Вопросы, связанные с генерацией и ценностью информации, стали ставиться сравнительно недавно. Ценность информации зависит от той цели, к которой стремиться воспринимающая информацию система (объект). Чем в большей мере информация способствует достижению цели, тем более ценной она считается. Здесь возможны два случая.

1) Цель наверняка достижима, причём разными способами. Ценность информации можно определить по тому, насколько эта информация помогает уменьшить затраты (материальные или временные) для достижения цели.

2) Цель достижима с некоторой вероятностью. В этом случае мерой ценности информации может служить величина

, (6.1)

, (6.1)

где P0 – вероятность достижения цели до получения информации (априорная вероятность), P1 - вероятность достижения цели после получения информации (апостериорная вероятность)[2]. Если до получения информации все варианты достижения цели равновероятны, то P0 =1/N, где N – число вариантов. Если варианты имеют разную вероятность, то можно воспользоваться формулой Шеннона и вычислить полную вероятность системы I и определить априорную вероятность из уравнения I = Log2(P0); т.е. P0 = 2-I.

Апостериорная вероятность P1 может быть: 1) больше P0 : P 1 > P0 ;

2) равна P0 : P 1 = P0 ; 3) меньше P0 : P 1 < P0 . В первом случае величина V, вычисленная по формуле (16), будет положительной. Это означает, что получена информация, которая будет способствовать достижению цели. Во втором случае V = 0, т.е. мы не получили никакой новой информации. В третьем случае V < 0 – это означает, что полученная информация будет мешать достижению цели. В этом случае мы имеем дело с дезинформацией. Значение V, найденное по формуле (6.1), изменяется в пределах от (-¥ ; Vmax), где Vmax = Log2(1/P0).

Другой способ измерения ценности V информации предложен В.И. Корогодиным:

(6.2)

(6.2)

Смысл обозначений такой же, как и в (6.1): P0 и P1 – априорная и апостериорная вероятности достижения (осуществления) цели Z. Значения V принадлежат интервалу (0 ; 1) при условии P1 > P0 . Если P1 = P0 , то V = 0; если P1 = 1, то V = 1.

Значения V не могут принимать отрицательные значения, т.к. ситуация, при которой P1 < P0 , может возникнуть лишь в двух случаях. Первый, когда объект, поставляющий или использующий информацию, стремится уменьшить вероятность осуществления некоторого события. Тогда цель для него - неосуществление Z, вероятность чего P' = 1- P0, и в этом случае P1, которое меньше, чем P0, будет превышать значение P', и, следовательно, требование V > 0 будет соблюдено. Второй случай – это ошибочное использование неподходящей информации, что требует коррекции, а не логического анализа. Ситуация с “сознательным обманом” целиком включается в первый случай.

Можно сделать вывод, что помимо количества информации, измерять и выражать в цифрах можно и такое ее свойство, как ценность. В основе определения ценности информации лежат такие ее свойства, как операциональность и эмерджентность, а также предложенный А. А. Харкевичем способ исчисления ценности через приращение вероятности достижения той цели, для чего данная информация используется.

Можно утверждать, что в отличие от количества, ценность информации невозможно задать одним единственным числом. Ценность каждой информации имеет определенное значение лишь по отношению к некоторой данной ситуации и данной цели: по отношению к разным парам “ситуация-цель” ценность любой информации может варьировать в некоторых пределах, например, от 0 до 1. Следовательно, мы никогда не сможем иметь исчерпывающие сведения о ценности какой-либо информации – сколь бы ни представлялась она ничтожной, всегда остается надежда, что могут существовать такие ситуации и цели, где эта ценность близка к максимальной, т.е. к единице.

Поэтому ценность информации, сообщаемой во время лекции преподавателем, неодинакова для каждого из судентов из-за существующих различий в тезаурусе и целях этих студентов. Здесь можно провести аналогию с вычислением работы силы по перемещению в заданном направлении: «вектор информации» и «вектор личных целей» могут быть сонаправлены, перпендикулярны или составлять острый угол.

studopedia.ru

Измерение количества информации

Определить понятие «количество информации» довольно сложно. В решении этой проблемы существуют два основных подхода. Исторически они возникли почти одновременно. В конце 40-х годов XX века основоположник теории информации, американский математик Клод Шеннон, развил вероятностный подход к измерению количества информации, а работы по созданию ЭВМ привели к «объемному» подходу.

Какое количество информации содержится, к примеру, в тексте романа, во фресках Рафаэля или в генетическом коде человека? Ответа на эти вопросы наука не даёт и, по всей вероятности, даст не скоро. А возможно ли объективно измерить количество информации? Важнейшим результатом теории информации является следующий вывод:

В определенных, весьма широких условиях можно пренебречь качественными особенностями информации, выразить её количество числом, а также сравнить количество информации, содержащейся в различных группах данных.

В настоящее время получили распространение подходы к определению понятия "количество информации", основанные на том, что информацию, содержащуюся в сообщении, можно нестрого трактовать в смысле её новизны или, иначе, уменьшения неопределённости наших знаний об объекте. Эти подходы используют математические понятия вероятности и логарифма.

Подходы к определению количества информации. Формулы Хартли и Шеннона.

Американский инженер Р. Хартли в 1928 г. процесс получения информации рассматривал как выбор одного сообщения из конечного наперёд заданного множества из N равновероятных сообщений, а количество информации H, содержащееся в выбранном сообщении, определял как двоичный логарифм N.

Формула Хартли:

Допустим, нужно угадать одно число из набора чисел от единицы до ста. По формуле Хартли можно вычислить, какое количество информации для этого требуется:  . Таким образом, сообщение о верно угаданном числе содержит количество информации, приблизительно равное 6,644 единицы информации.

. Таким образом, сообщение о верно угаданном числе содержит количество информации, приблизительно равное 6,644 единицы информации.

Приведем другие примеры равновероятных сообщений:

1. при бросании монеты: "выпала решка", "выпал орел";

2. на странице книги: "количество букв чётное", "количество букв нечётное".

Определим теперь, являются ли равновероятными сообщения "первой выйдет из дверей здания женщина" и "первым выйдет из дверей здания мужчина". Однозначно ответить на этот вопрос нельзя. Все зависит от того, о каком именно здании идет речь. Если это, например, станция метро, то вероятность выйти из дверей первым одинакова для мужчины и женщины, а если это военная казарма, то для мужчины эта вероятность значительно выше, чем для женщины.

Для задач такого рода американский учёный Клод Шеннон предложил в 1948 г. другую формулу определения количества информации, учитывающую возможную неодинаковую вероятность сообщений в наборе.

Формула Шеннона: H = — ( p1log2 p1 + p2 log2 p2 + . . . + pN log2 pN),

где pi — вероятность того, что именно i-е сообщение выделено в наборе из N сообщений.

Легко заметить, что если вероятности p1, ..., pN равны, то каждая из них равна 1 / N, и формула Шеннона превращается в формулу Хартли.

Помимо двух рассмотренных подходов к определению количества информации, существуют и другие. Важно помнить, что любые теоретические результаты применимы лишь к определённому кругу случаев, очерченному первоначальными допущениями.

В качестве единицы информации Клод Шеннон предложил принять один бит (англ. bit — binary digit — двоичная цифра).

Бит в теории информации — количество информации, необходимое для различения двух равновероятных сообщений (типа "орел"—"решка", "чет"—"нечет" и т.п.) В вычислительной технике битом называют наименьшую "порцию" памяти компьютера, необходимую для хранения одного из двух знаков "0" и "1", используемых для внутримашинного представления данных и команд.

Бит — слишком мелкая единица измерения. На практике чаще применяется более крупная единица — байт, равная восьми битам. Именно восемь битов требуется для того, чтобы закодировать любой из 256 символов алфавита клавиатуры компьютера (256=28).

Широко используются также ещё более крупные производные единицы информации:

· 1 Килобайт (Кбайт) = 1024 байт = 210 байт,

· 1 Мегабайт (Мбайт) = 1024 Кбайт = 220 байт,

· 1 Гигабайт (Гбайт) = 1024 Мбайт = 230 байт.

В последнее время в связи с увеличением объёмов обрабатываемой информации входят в употребление такие производные единицы, как:

· 1 Терабайт (Тбайт) = 1024 Гбайт = 240 байт,

· 1 Петабайт (Пбайт) = 1024 Тбайт = 250 байт.

За единицу информации можно было бы выбрать количество информации, необходимое для различения, например, десяти равновероятных сообщений. Это будет не двоичная (бит), а десятичная (дит) единица информации.

studopedia.ru

Читайте также

![Представителем онтологического подхода в определении предмета философии Представителем онтологического подхода в определении предмета философии]() Представителем онтологического подхода в определении предмета философии

Представителем онтологического подхода в определении предмета философии![Определение документооборота с точки зрения информации Определение документооборота с точки зрения информации]() Определение документооборота с точки зрения информации

Определение документооборота с точки зрения информации- Основные подходы к определению сущности права

![Российский законодатель дает определения понятию информация Российский законодатель дает определения понятию информация]() Российский законодатель дает определения понятию информация

Российский законодатель дает определения понятию информация![Определение количества информации Определение количества информации]() Определение количества информации

Определение количества информации![Акт определение Акт определение]() Акт определение

Акт определение- Актив определение

![База данных определение База данных определение]() База данных определение

База данных определение![Болезнь определение Болезнь определение]() Болезнь определение

Болезнь определение![Власть определение Власть определение]() Власть определение

Власть определение![Выберите верное определение материи Выберите верное определение материи]() Выберите верное определение материи

Выберите верное определение материи![Дайте определение понятию авария Дайте определение понятию авария]() Дайте определение понятию авария

Дайте определение понятию авария

Представителем онтологического подхода в определении предмета философии

Представителем онтологического подхода в определении предмета философии Определение документооборота с точки зрения информации

Определение документооборота с точки зрения информации Российский законодатель дает определения понятию информация

Российский законодатель дает определения понятию информация Определение количества информации

Определение количества информации Акт определение

Акт определение База данных определение

База данных определение Болезнь определение

Болезнь определение Власть определение

Власть определение Выберите верное определение материи

Выберите верное определение материи Дайте определение понятию авария

Дайте определение понятию авария